近期,科技界迎來了一項重要突破,英偉達攜手麻省理工學院(MIT)及香港大學,共同推出了Fast-dLLM框架,這一創新成果旨在顯著提升擴散模型(Diffusion-based LLMs)的推理速度,為語言生成任務帶來了全新的可能性。

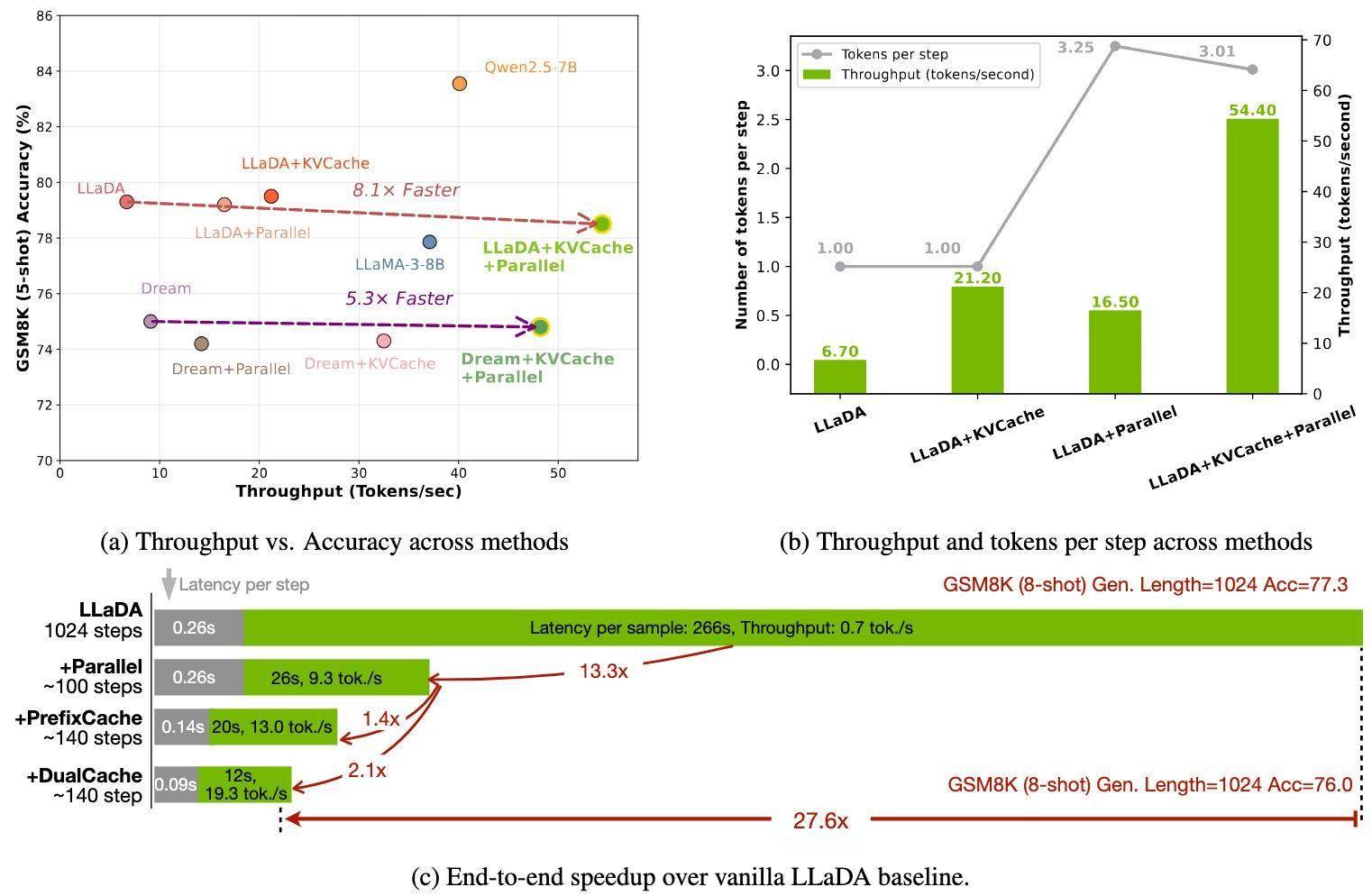

擴散模型,作為傳統自回歸模型的有力挑戰者,憑借其雙向注意力機制,理論上能夠實現多詞元同步生成,從而加速解碼過程。然而,在實際應用中,擴散模型的推理速度卻往往不盡如人意。原因在于,每次生成步驟都需要重新計算全部注意力狀態,這導致了高昂的計算成本。多詞元同步解碼時,詞元間的依賴關系容易受到破壞,進而影響生成質量,使得擴散模型難以滿足實際應用的需求。

為了突破這一瓶頸,英偉達聯合團隊研發了Fast-dLLM框架,該框架引入了兩大核心創新:塊狀近似KV緩存機制和置信度感知并行解碼策略。這一創新設計,為擴散模型的推理速度和質量帶來了顯著提升。

在Fast-dLLM框架中,KV緩存機制通過將序列劃分為塊,預計算并存儲其他塊的激活值,以便在后續解碼中重復利用,從而顯著減少了計算冗余。而其DualCache版本更進一步,緩存了前后綴詞元,利用相鄰推理步驟的高相似性,進一步提升了效率。這一機制的實施,為擴散模型的推理速度帶來了質的飛躍。

另一方面,置信度解碼策略則根據設定的閾值,選擇性解碼高置信度的詞元,從而避免了同步采樣帶來的依賴沖突,確保了生成質量。這一策略的實施,使得擴散模型在保持高質量生成的同時,進一步提升了推理速度。

Fast-dLLM框架在多項基準測試中均展現出了驚人的表現。在GSM8K數據集上,生成長度為1024詞元時,其8-shot配置下實現了27.6倍的加速,準確率高達76.0%。在MATH基準測試中,加速倍數為6.5倍,準確率約為39.3%。而在Humaneval和MBPP測試中,分別實現了3.2倍和7.8倍的加速,準確率維持在54.3%和基線水平附近。這些測試結果表明,Fast-dLLM框架在加速推理的同時,僅犧牲了1-2個百分點的準確率,成功實現了速度與質量的平衡。

Fast-dLLM框架的成功推出,標志著擴散模型在實際語言生成任務中具備了與自回歸模型競爭的實力。這一創新成果不僅解決了推理效率和解碼質量問題,更為擴散模型的廣泛應用奠定了堅實基礎。未來,我們有理由相信,隨著技術的不斷進步和完善,擴散模型將在更多領域展現出其獨特的優勢和潛力。