阿里巴巴通義實(shí)驗(yàn)室近期宣布了一項(xiàng)重大開源成果——音頻生成模型ThinkSound,這一創(chuàng)新之舉標(biāo)志著AI在音頻創(chuàng)作領(lǐng)域邁出了重要一步。ThinkSound的獨(dú)特之處在于,它首次引入了CoT(思維鏈)技術(shù),使AI能夠模擬專業(yè)音效師的思考過程,精準(zhǔn)捕捉視覺細(xì)節(jié),并生成與畫面完美同步的高保真音頻。

據(jù)悉,ThinkSound的代碼和模型已在Github、HuggingFace及魔搭社區(qū)等平臺(tái)全面開源,供開發(fā)者免費(fèi)下載和體驗(yàn)。這一開放舉措無疑將極大地推動(dòng)音頻生成技術(shù)的發(fā)展,激發(fā)更多創(chuàng)新應(yīng)用。

在多媒體編輯和視頻內(nèi)容創(chuàng)作領(lǐng)域,視頻生成音頻(V2A)技術(shù)一直備受關(guān)注。然而,現(xiàn)有技術(shù)往往難以準(zhǔn)確捕捉畫面中的動(dòng)態(tài)細(xì)節(jié)和時(shí)序信息,導(dǎo)致生成的音頻與關(guān)鍵視覺事件錯(cuò)位,無法滿足專業(yè)創(chuàng)意場(chǎng)景的高要求。針對(duì)這一難題,通義實(shí)驗(yàn)室將思維鏈推理引入多模態(tài)大模型,實(shí)現(xiàn)了對(duì)視覺事件與聲音之間深度關(guān)聯(lián)的精準(zhǔn)建模。

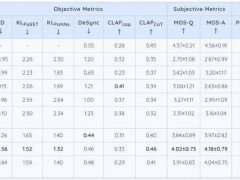

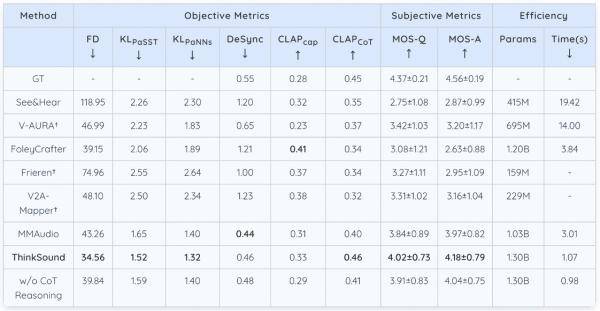

為了進(jìn)一步提升模型的性能,通義團(tuán)隊(duì)還構(gòu)建了首個(gè)帶思維鏈標(biāo)注的音頻數(shù)據(jù)集AudioCoT。該數(shù)據(jù)集融合了超過2500小時(shí)的多源異構(gòu)數(shù)據(jù),為模型在音頻生成與編輯任務(wù)中提供了豐富的訓(xùn)練素材。得益于此,ThinkSound在開源的VGGSound測(cè)試集上表現(xiàn)優(yōu)異,多項(xiàng)核心指標(biāo)均超越了現(xiàn)有主流方法。

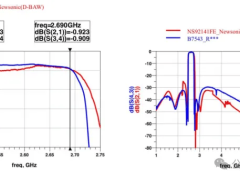

具體而言,在openl3空間中Fréchet 距離(FD)這一指標(biāo)上,ThinkSound相比MMAudio降低了近9個(gè)點(diǎn),接近真實(shí)音頻分布的相似度提高了20%以上。同時(shí),在代表模型對(duì)聲音事件類別和特征判別精準(zhǔn)度的KLPaSST 和 KLPaNNs兩項(xiàng)指標(biāo)上,ThinkSound也取得了同類模型中的最佳成績(jī)。

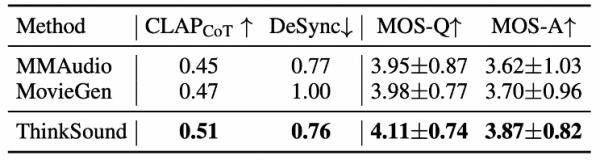

在MovieGen Audio Bench測(cè)試集上,ThinkSound同樣展現(xiàn)出了強(qiáng)大的實(shí)力,大幅領(lǐng)先于meta推出的音頻生成模型Movie Gen Audio。這一表現(xiàn)不僅證明了ThinkSound在影視音效、音頻后期等領(lǐng)域的廣泛應(yīng)用潛力,也為其在游戲與虛擬現(xiàn)實(shí)音效生成等前沿領(lǐng)域的應(yīng)用奠定了堅(jiān)實(shí)基礎(chǔ)。

通義實(shí)驗(yàn)室在音頻生成領(lǐng)域的布局遠(yuǎn)不止于此。此前,該實(shí)驗(yàn)室已推出語音生成大模型Cosyvoice和端到端音頻多模態(tài)大模型MinMo等,全面覆蓋了語音合成、音頻生成、音頻理解等多個(gè)場(chǎng)景。此次ThinkSound的開源,無疑將進(jìn)一步鞏固通義實(shí)驗(yàn)室在音頻生成領(lǐng)域的領(lǐng)先地位。